بخش اول این مقاله را میتوانید از اینجا مطالعه کنید .

انواع RAID پشتیبانی شده HPE MSA

کلیه تنظیمات RAID ارائه شده در این بخش( علی رغم دارا بودن نقاط ضعف و قوت)، قابلیت به کارگیری و استفاده در محیط vSphere را دارند.

RAID 0 (block level striping)

درHPE MSA RAID 0 به عنوان مجموعه بدون استریپ یا ولوم غیر استریپد شده نیز شناخته می شود و بلوک های داده ایی را به صورت ترتیبی( یعنی یک دیسک در هر زمان) برای کلیه دیسک های موجود در پیکر بندی حفظ می کند. از نجایی که در این روش ذخیره سازی هیچ گونه سرباری وجود ندارد، این روش به عنوان سریعترین روش خواندن و نوشتن داده محسوب می شود. عیب اصلی این روش عدم استفاده از پریتی برای کنترل خطا است. بنابراین در صورتی که دیسکی با مشکل مواجه شود، کل داده های موجود در آن از بین می روند. از آنجایی که RAID 0 در محیط های تولیدی توصیه نشده استو فقط می توانند با استفاده از رابط خط فرمان ایجاد شوند، SMU ایجاد دیسک های گروهی را با RAID 0 پشتیبانی نمی کند.

RAID 1 (mirroring)

RAID 1 شیوه ذخیره سازی آیینه ایی یک به یک از یک دیسک فیزیکی است. از آنجایی که در این روش تمام اطلاعات ذخیره شده به صورت آیینه ایی روی هر دو درایو استفاده شده نوشته می شود این روش می تواند نسبت به خراب شدن یک درایو ایمن باشد چرا که نسخه دیگری از داده ها دقیقا بر روی درایو دیگر نوشته شده است.

RAID 5+0 ( RAID 50 ) با دیسک گروه های مجازی پشتیبانی نمی شود

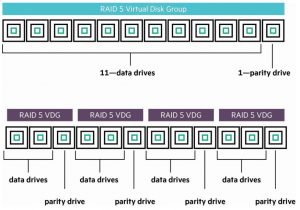

RAID 5 ( پریتی توزیع شده + استریپینگ) داده ها را بر روی مجموعه ایی دیسک های سخت ذخیره می کند و پریتی داده ها را محاسبه کرده و پریتی محاسبه شده را بر روی یک مجموعه هارد دیسک می نویسد. سپس همان پریتی را بر روی دیسک دیگری در مجموعه می نویسد. این کار به دلیل فراهم کردن امکان بیشتر استریپ کردن داده ها انجام می شود. ترکیب استریپینگ RAID 0 سبب افزایش کارایی در این پیکر بندی می شود.

از جمله معایب این پیکر بندی می توان به افزایش کلی هزینه ها و کاهش فضای ذخیره سازی دردسترس اشاره کرد. برای نوشتن بر روی محیط RAID 5، بلوک های موثر ابتدا خوانده می شوند، داده تغییر یافته وارد می شود و پریتی جدید محاسبه می شود و در نهایت بلوک نوشته می شود. در سیستم هایی که از مجموعه های بزرگ RAID 5 استفاده می کنند این توضیحات نشان دهنده آن است که نوشتن I/O نسبت به خواندن I/O به مراتب کندتراست و همین گزینه نکته ایی غیر مطلوب و ناخوشایند برای مجازی سازی سرور به شمار می رود.

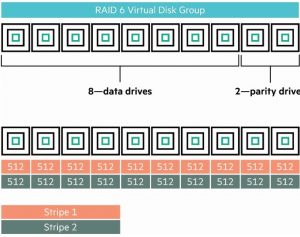

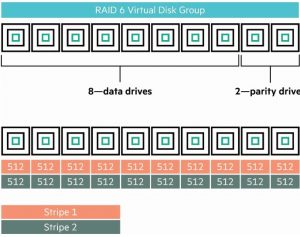

RAID 6 ( پریتی توزیع شده چندگانه همراه با قابلیت پشتیبانی از استریپینگ)

RAID 6 به عنوان سطح پیش فرض RAID و سطح محافظت توصیه شده HPE برای گروه های دیسک مجازی محسوب می شود. این پیکربندی ذخیره سازی مشابه با RAID 5 است. البته نسبت به RAID 5 دارای یک بلوک پریتی ثانویه است. به هرحال اضافه شدن پریتی ثانویه در این پیکربندی علی رغم آنکه بر روی عملیات خواندن تاثیری نمی گذارد اما به علت سربار ناشی از محاسبات مربوط به پریتی ها در بحث نوشتن با افت کارایی روبرو می شود.

RAID 10( شیوه های ذخیره سازی آیینه ایی و استریپینگ)

RAID 10 ( با عنوان RAID 1+0 نیز شناخته می شود) داده ها را به سبک استریپ در دیسک های اولیه می نویسد. هر کدام از دیسک های اولیه دارای دیسک های ثانویه هستند که ذخیره اطلاعات به سبک ایینه ایی در آنها صورت می گیرد. مجازی سازی سرور با این سبک ذخیره سازی به خوبی سازگار بوده و کار می کند. همچنین در این سبک ذخیره سازی به علت استفاده از استریپینک سطح بلوکی و تکرار ولوم های آیینه ایی شده بر روی دیسک های فیزیکی مجزا و مدیریت درخواست های اضافی I//O ، شاهد افزایش کارایی هستیم.

بهترین گزینه برای انتخاب: در پیکربندی های ذخیره سازی بزرگ، به جای استفاده از گروه های دیسک زیاد و داشتن درایو های کمتر، گروه های دیسک را کوچک در نظر بگیرید به صورتی که درایو های بیشتری داشته باشید.

این تکنیک نه تنها سبب استفاده بهینه تر از فضای ذخیره سازی می شود بلکه کارایی را در طول عملیات های نوشتن در گروه دیسک بهبود می بخشد. برای مثال، یک گروه دیسک RAID 6 با 12 درایو SAS، که از میان آنها 2 درایو برای پریتی و 10 درایو دیگر برای ذخیره سازی داده استفاده می شود. همین تعداد درایو را در یک دیسک گروه چهار تایی RAID 5 مقایسه کنید. در این حالت هر گروه دیسک یک درایو پریتی و 2 درایو ذخیره سازی خواهد داشت. مشاهده می شود که در حالت اول فقط 2 درایو به پریتی اختصاص یافته است در حالی که در روش دوم 4 دراوی به پریتی اختصاص یافته است. این امر علاوه بر تلف شدن فضای ذخیره سازی و تحمیل سربارهای ناشی از محاسبه پریتی ها، بر کارایی و عملکرد کلی سیستم نیز تاثیر گذار خواهد بود و سبب تنزل آن می شود( تصویر زیر مقایسه فوق را نشان می دهد).

ولوم های مجازی

ولوم های مجازی، زیر مجموعه های منطقی از استخر ذخیره سازی هستند که از طریق پورت های کنترلر متصل به میزبان vSphere در دسترس قرار دارند. این گونه تجهیزات پیچیدگی های مربوط به ویژگی های استخر ذخیره سازی و گروه دیسک ها ( شامل استریپینگ، Read Cache و Data Tiering )، نگاشت محیط vSphere به عنوان دیتا استورهای VMFS یا RDM ها را پنهان می کنند. HPE MSA 2042 به ازای هر استخر ذخیره سازی توانایی دربرگرفتن 1024 ولوم مجازی را دارد. هر ولوم مجازی قابلیت ست شدن با یک [1]Tier Affinity را دارد که به Tier type های ایجاد شده در گروه های دیسک مجازی نگاشت شده است. در حالت پیش فرض، ولوم های مجازیبه صورت No Affinity تنظیم شده اند و شرکت HP نیز برای اکثر پیکر بندی ها همین گزینه را پیشنهاد داده است. هدف اصلی این گونه تنظیمات ایجاد بالانس و تعادل در فرکانس دسترسی به داده، هزینه دیسک و دسترسی پذیری دیسک است و این هدف را از طریق انتقال داده های موجود در این ولوم ها به TIER های مناسب انجام می دهد.

انتخاب بهترین شیوه :

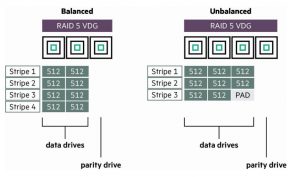

تا حد امکان ازمدل توان 2 استفاده کنید.

هنگام ایجاد گروه های دیسک مجازی، تعداد درایوهای داده ایی موجود در گروه RAID را به صورت مضربی از 2 حفظ کنید.HPE MSA داده ها را در چانک های (صفحات) 4 مگا بایتی می نویسد. متعادل نگه داشتن رایت چانک های 4 مگابایتی با رعایت توان 2 بودن تعداد درایوهای داده ایی سبب بهبود کارایی می شود. برای مثال، پیکربندی بهینه برای گروه دیسک مجازی RAID 6 ، ده درایو است. دو درایو برای پریتی و 8 درایو برای ذخیره داده. از آنجایی که استریپینگ به صورت همزمان در 8 درایو انجام می شود، بنابراین برای چانک 4 مگا بایتی، استریپ یکبار انجام می شود ( یعنی 8 x 512 KB = 4 MB ).

ارائه LUN یکپارچه (Unified LUN Presentation (ULP))

آرایه ذخیره سازی HPE MSA از ارائه ULP پشتیبانی می کند. در نسخه 3 SMU، ULP عملا از طریق استفاده از مخازن ذخیره سازی و ولوم های مجازی از دید مدیران به صورت مجازی پنهان شده است. ولوم های مجازی از طریق هر دو کنترل کننده روی HPE MSA پشتیبانی شده اند و نیاز به مشخص کردن مسیر اتصالات بین کنترل کننده های ذخیره سازی و میزبان های هدف را حذف کرده اند. از آنجا که در HPE MSA مالک مخازن ذخیره سازی با کنترلرها در ارتباط است، SMU از طریق جلوگیری از تکرار شدن ولوم های مجازی ایجاد شده در مخازن ذخیره سازی، ULP را اعمال می کند.

به علت آنکه هر دو کنترلر توانایی دستیابی به ولوم های مجازی موجود در هر دو مخزن ذخیره سازی را دارند، یک مسیر مناسب توسط دسترسی واحد منطق نامتقارن (ALUA) شناسایی می شود. این کار بخشی از پروتکل RTPG است که مخزن مربوط به ولوم مجازی را مشخص می کند و سپس مسیر بهینه ایی را برای دسترسی به آن مشخص می نماید. در این حالت، کنترلر مرتبط با مخزن ذخیره سازی، به صورت همیشگی عملیات های I/O را برای این گونه درخواست ها اجرا می کند.

ولوم های مجازی در دید میزبان به صورت یک سیستم ذخیره سازی فعال- فعال دیده می شوند و در آن میزبان توانایی انتخاب مسیرهای دردسترس را برای دسترسی به ولوم مجازی دارد. البته در این نمونه مالک مخزن ذخیره سازی استثناء است.

توانایی مشخص کردن و جایزگین نمودن مالک کنترلر LUN با استفاده از ALUA موجود در استاندارد SPC-3 مشخص می شود. ارایه استوریج HPE MSA توانایی پشتیبانی از مدهای ALU را دارد. این امر به معنی آن است که ارایه توانایی تخیصیص و تغییر مدیریت کنترلر برای یک ULN را دارد، به هر حال مالک ULN توانایی تخصیص یافتن به یک کنترلر خاص HPE MSA را ندارد.

مروری بر عملیات ULP

ULP کلیه ولوم های مجازی به کلیه پورت های میزبان را ارائه می کند.

- نیاز به مشخص کردن مسیرهای ویژه درون اتصالی کنترل کننده ها را حذف می کند.

- همان WWNN را برای هر دو کنترل کننده آرایه ایی ارائه می دهد.

ULP ، ولوم های مجازی را بین کنترل کننده ها به اشتراک می گذارد

- هیچ گونه تکراری از ولوم های مجازی در میان کنترلر های ارایه ایی مجاز نیست.

- هر یک از کنترل کننده ها می توانند از ولوم مجازی استفاده نشده، استفاده کنند.

ULP مسیرهای ترجیح داده ( مناسب) را می شناسد

- مسیر مناسب یا ترجیح داده شده نشان می دهد که مالکیت کنترل کننده مربوط به استخر ذخیره سازی ولوم های مجازی است از مشخصات ALUA تبعیت می کند.

- RTPG مسیرهای مورد مناسب را شناسایی می کند.

- در صورت عدم استفاده از مسیرهای مناسب و ترجیح داده شده، کارایی کاهش می یابد.

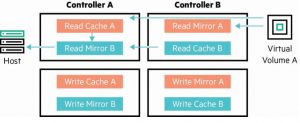

پردازش نوشتن I / O با ULP.

برای لحظه ای در نظر بگیرید که چگونه ULP با استفاده از مثال Host به Virtual Volume زیر کار می کند

- دستوری را بر روی کنترلر A برای ولوم مجازی A بنویسید.

- کنترل کننده A می داند VVA در مخزن B قرار دارد و متعلق به کنترلر B است.

- داده ها در کش کنترلر A نوشته می شوند.

- سپس کنترلر A همان داده را به صورت VVA ایینه ایی بر روی کنترلر B انتشار می دهد.

- کنترل کننده A تأیید I / O را به میزبان می دهد.

- داده ها توسط کنترلر B از آینه کنترل کننده A بر روی VVA نوشته می شوند.

پروسه خواندن I/O با ULP

دستور خواندن به کنترلر A برای VVA که مالک آن کنترلر B باشد به شرح زیر خواهد بود:

- در صورتی که داده VVA در کش رید (حافظه نهان خواندن) کنترلر B باشد، کنترلر A از کنترلر B آن را درخواست می کند.

- اگر باشد، کنترلر B به کنترلر A مکان آن را اطلاع می دهد و آن را به A منعکس می کند.

- کنترلر A به شیوه آیینه ایی، از کنترلر B ، داده مورد نظر را به میزبان ارسال می کند و I/O را کامل می کند.

- اگر داده پیدا نشود، درخواست به کنترلر B فرستاده می شود تا داده مورد نظر از دیسک فراخوانی شود.

- بعد از آن داده در کش رید کنترلر B قرار داده می شود و را به آیینه کنترلر A منعکس می کند.

- بعد از آن داده از طریق کنترلر A از کش رید آیینه کنترلر B با تکمیل I/O به میزبان فرستاده می شود.

با شکست مواجه شدن ارائه LUN یکپارچه ( ULP)

اگر واحد کنترلر بر روی کنترلر دوگانه آرایه استوریج HPE MSA با مشکل مواجه شود، مالک مخزن ذخیره سازی از کنترلر خراب به کنترلر ثانویه انتقال داده می شود یا انکه از کنترلر موجود در ارایه بک آپ تهیه می کند.

بعد از رخداد شکست، مخزن ذخیره سازی و کلیه دیسک گروه های مرتبط به کنترلر به کنترلر ثانویه انتقال داده می شوند. به دلیل ULP، فقط یکی از ارائه های WWNN ( گره های نام گسترده جهانی) خودش را در اختیار کنترلر نجات دهنده قرار می دهد. نرم افزار Multipath نیز به تامین مسیرهای i/o /برای کنترلر نجات دهنده ادامه می دهد.

توانایی و قابلیت تعریف و مشخص کردن ولوم مجازی برای مالک کنترلر توسط توسعه های alua در استاندارد SPC-3 مشخص می شود. آرایه ذخیره سازی HPE MSA مدهای ALUA را به صورت مجازی سازی شده و از طریق مخازن ذخیره سازی، گروه های دیسک مجازی و ولوم های مجازی پشتیبانی می کند.

حفاظت از داده با استفاده از تکنیک Remote Snap در HPE MSA

محافظت از داده ها با هزینه ای موثر چالشی برای کسب و کارهای کوچک و متوسط محسوب می شود. آرایه ذخیره سازی HPE MSA و قابلیت Remote Snap آن یک راه حل واقعی را برای کسب و کارهایی فراهم می کند که نیاز به حفاظت از داده ها و افزونگی دارند.Remote Snap یک ویژگی تکرار مبتنی بر آرایه است که بین دو سیستم ذخیره سازی HPE MSA اجرا می شود. با استفاده از پیکربندی آرایه ذخیره سازی دوگانه، داده ها از طریق تکرار داده ها به صورت آنی و بدون تحمیل هزینه های سنگین ، محافظت می شوند. برای کسب اطلاعات بیشتر، سند HPE MSA Remote Snap Software را ببینید.

توصیه های HPE MSA و شیوه های رایج

نصب و راه اندازی ذخیره سازی HPE MSA 2040/2042/2050/2052

از آنجا که دستگاه های ذخیره سازی نقش حیاتی را در موفقیت یک VMware vSphere ایفا می کنند، نصب و پیکربندی درست HUSE MSA Storage Array اهمیت فراونی دارد. تیم توسعه HPE MSA تنظیمات پیش فرض مجموعه آرایه های ذخیره سازی HPE MSA را به منظور عملکرد بهینه تنظیم کرده است. همچنین این تنظیمات برای محیط های مجازی سازی نیز ارائه شده است.

بخش زیر برخی از نکات کلیدی و اصلی مربوط به نصب، راه اندازی و پیکربندی آرایه ذخیره سازی HPE MSA را شرح داده است. برای مشاهده توصیه های خاص مربوط به آرایه ذخیره سازی HPE MSA و محیط مجازی سازی VMware vSphere،به بخشی از این سند تحت عنوان ملاحضات HPE MSA و بهترین کارها برای vSphere مراجعه کنید.

منابع دیگر، مانند راهنماهای پیکربندی HPE MSA، می توانند اطلاعات دقیقی را درباره نصب ارائه دهند. برای دیدن این منابع می توانید به وب پیج HPE MSA مراجعه کنید. این منابع عبارتند از

- The HPE MSA 2040 User Guide

- The HPE MSA 2040 Cable Configuration Guide

- The HPE MSA 1040/2040 SMU Reference Guide

- The HPE MSA 2050 User Guide

- The HPE MSA 2050 SMU Reference Guide

توسعه کابل کشی آرایه ذخیره سازی HPE MSA

آرایه ذخیره سازی HPE MSA از هر دو نوع کابل کشی مبتنی بر تحمل خطا و کابل کشی مستقیم SAS پشتیبانی می کند .کابل کشی مبتنی بر تحمل خطا به کلیه محفظه های درایو اجازه می دهد در هنگام برزو خطا ضمن حذف درایو فعلی به محفظه های دیگر دسترسی داشته باشند. هنگامی اتصال چند محفظه درایو، استفاده از کابل کشی تحمل خطا به منظور به دست آوردن بالاترین سطح تحمل خطا توصیه می شود.

علی رغم انکه کنترلر های HPE MSA به صورت همزمان قابلیت اتصال به کانکشن های iSCSI و کانال فیبر را دارند، اما هرگز نباید هر دو پورت FC و iSCSI را برای یک ولوم مشابه موجود در سرور پیکر بندی کنید.

راه حل های میزبان چند مسیره از طریق تلاش برای به دست آوردن تعادل در بین پروتکل هایی که کارایی و عملکرد مشابهی ندارند، تمایل به اشتباه دارند. هر چند که iSCSI قابلیت پشتیبانی از پکتهای متوالی را دارد و پروتکل ی فایبر کانال این خاصیت را ندارند.

برای دیدن اطلاعات و جزییات بیشتر در مورد نیازمندیهای کابل کشی در وب پیج HPE MSA به منابعی همچون HPE MSA 2040 Cable Configuration Guide یا HPE MSA 2050 Cable Configuration Guide. مراجعه کنید.

- منبع تغذیه

- پورت های اتصال میزبان

- پورت CLI (mini-USB)

- پورت مدیریت اترنت

- پورت توسعه SAS

استفاده از پیکر بندی با دارا بودن سویچ های دوگانه FC برای ارتباط میزبان با آرایه HPE MSA بهترین شیوه است و افزونگی عالی را پیشنهاد می دهد. برای نیازمندیهای کابل کشی ذخیره سازی HPE MSA و گزینه های آن به HPE MSA 2040 User Guide و HPE MSA 2050 User Guide. مراجعه کنید.

سویچ های FC و گیرنده- فرستندهای ( ترانسیورهای) SFP

علی رغم پیشرفت های به وجود آمده در بحث استاندارد سازی ترانسیورهای قابل نصب فرم فاکتور کوچک (SFP)، تمام آنها با هم مشابه و برابر نیستند و همه آنها با هر دستگاهی منطبق نمی شوند. SFP ها برای کانال های فیبری، سویچ های اترنت و اداپتورهای در سرعت های متفاوت ارائه شده اند.

استفاده از SFP اشتباه می تواند به ذخیره سازی تعبیه شده در استوریج HPE MSA صدمه وارد کند. بنابراین به منظور مشاهده ترانسیورهای SFP قابل پشتیبانی توسط استوریج های 2052 و 2042 برای سویچ های FC و iSCSI به hpe.com/storage/san مراجعه کنید.

همچنین به منظور به دست آوردن اطلاعات بیشتر در مورد کابل کشی استوریج های HPE MSA به HPE MSA 2040 Cable Configuration Guide یا HPE MSA 2050 Cable Configuration Guide در کتابخانه اطلاعات تجاری هولت پکارد (Hewlett Packard Enterprise Information Library) مراجعه کنید.

پیکر بندی اولیه

هنگامی که برای اولین بار استوریج HPE MSA را نصب می کنید، به منظور حصول اطمینان از به دست آوردن بهترین نتایج نصب، کارهای زیر را انجام دهید. بهترین اعمال برای محیط VMware vSphere را می توانید در بخش ملاحضات HPE MSA و بهترین اعمال برای vSphere مطالعه کنید.

بهینه سازی برای سریعترین کارایی

هنگام پیکربندی سیستم ذخیره سازی برای سریعترین توانایی، به یاد داشته باشید:

- پیکربندی پورت های میزبان برای سریعترین سرعت انتقال امکان پذیر است.

- برقراری تعادل بین گروه های دیسک دو استخر HPE MSA

- یک گروه دیسک کش رید را به هر استخر ذخیره سازی اضافه کنید.

- برای به حداکثر رساندن عملکرد دائمی برای یک استخر ذخیره سازی، به ازای هر مخزن فقط یک ولوم ایجاد کنید

- به منظور اطمینان از عملکرد مطلوب ولوم های مجازی را به پورت های میزبان نگاشت دهید.

- با استفاده از مدل توان 2، تا حد امکان بار را در بیشترین تعداد درایو توزیع کنید.

بهینه سازی تحمل پذیری در برابر خطا برای HPE MSA

به منظور به دست آوردن بالاترین تحمل پذیری خطا در هنگام نصب و راه اندازی سیستم استوریج، اعمال زیر رانجام دهید

- استفاده از کنترلرهای دوگانه

- استفاده از دو کابل اتصال برای هر میزبان

- تهیه سویچ های FC چندگانه برای پیکر بندی SAN( توصیه شده برای افزونگی بهتر)

- استفاده از نرم افزار چندمسیره I/O ( MPIO).

ملاحضات نوع RAID گروه دیسک

RAID 6، هنگام استفاده از درایوهای SAS میانی در آرشیو های تایر، پیکر بندی توصیه شده است. افزونگی اضافه شده RAID 6 از وقوع از دست رفتن داده در مواقع خرابی دیسک ثانویه با درایوهای بزرگ MDL SAS جلوگیری می کند و از آنها محافظت می کند.

RAID 5 معمولا برای استاندارد تایر استفاده می شود به صورتی که در آن دیسک ها کوچکتر و سریعتر هستند و زمان های بازساخت کوتاه تری دارند. این پیکر بندی در حجم کارهایی استفاده می شود که به صورت ذاتی ترتیبی و تصادفی هستند.

برای مشاهده انواع RAID های به کار رفته در کش رید و کارایی تایر به بخش بهترین کارها برای SSD ها مراجعه کنید.

Disk Sparing

به طور پیش فرض، HPE MSA Storage امکان Sparing پویا را فراهم می کند. این به معنی آن است یک درایو ازاد و اختصاص نیافته به گروه دیسک مجازی به صورت پویا قابلیت جایگزینی با درایو گروه دیسک مجازی را دارد که در حال تنزل و افت کارایی است. هنگامی که یک دیسک موجود در گروه دیسک مجازی با مشکل مواجه می شود، نرم افزار HPE MSA به دنبال نمونه عمومی سازگار می گردد. در صورتی که یکی از آن را بیابد، سیستم عامل به صورت خودکار و پویا آن را برای درایو خراب جایگزن می کند و به صورت خودکار گروه دیسک مجازی را مجددا ایجاد می کند. اگر دیسک سازگاری وجود نداشته باشد، ارایه هشدار خرابی دیسک را ارسال می کند. جایگزینی دیسک خراب با دیسک سازگار به صورت باز ساخت خودکار انجام می شود.

در طول بازساخت داده، تا زمانی که پریتی یا داده های انعکاسی به صورت کامل در ناحیه جدید درج نشوند، گروه دیسک مجازی در موقعیت بحرانی قرار می گیرد و از کارایی آن کاسته می شود. بعد از کامل شدن کار، گروه دیسک مجددا به وضعیت تحمل پذیری در برابر خطا باز می گردد.

» بهترین کار: برای sparing پویا در هر گروه دیسک مجازی با قابلیت تحمل پذیری خطا، حداقل یک دیسک سازگار در نظر بگیرید.

Virtual Volume Affinity

HPE در اکثر پیکر بندی های خود به صورت پیش فرض از گزینه No Affinity استفاده می کند. این نوع تنظیمات یعس دارند تا میان فرکانس دسترسی به داده، هزینه دیسک و دسترسی پذیری دیسک نوعی تعادل را از طریق انتقال داده ولوم به بهترین دیسک تایر به وجود آورند. در این تنظیمات مشخص می شود که برای اولین بار داده در کجای ولوم ذخیره شود. برای مثال، اگر این ولوم برای فیلم های کاربران در نظر گرفته شده باشد، کاربران نمی توانند تماشای فیلم را در اغلب اوقات پیش بینی کنند در این صورت تنظیمات volume affinity به صورت آرشیوی در نظر گرفته می شود. این امر بدان معنی است فایل هایی که در این ولوم کپی می شوند، ابتدا در بخش ارشیوی گروه دیسک مجازی نوشته می شوند.

اگر ولوم مجازی عمدتا از حجم کارهایی که دارای تاخیر کم یا تصادفی مانند (OLTP) پردازش آنلاین تراکنش ها ، زیر ساخت دسک تاپ مجازی (VDI) یا محیط های مجازی سازی استفاده کند، HPE استفاده از تنظیمات Performance را پیشنهاد می دهد. این نوع تنظیم تا حد ممکن داده های موجود در ولوم را در بخش کارایی ولوم می نویسد.

اگر ولوم مجازی دربرگیرنده داده هایی هستند که میزان دسترسی به آنها کم است، مانند داده های پشتیبان یا ایمیل های ارشیو شده، استفاده از تنظیمات Archive ، گزینه توصیه شده توسط HPE خواهد بود. در این حالت داده های موجود در این ولوم تا حد امکان در بخش ارشیوی ولوم نگهداری می شوند.

بهترین تمرین : برای محیط های مجازی سازی، OLTP, VDI ، تنظیمات مربوط به volume affinity را در حالت Performance ست کنید.

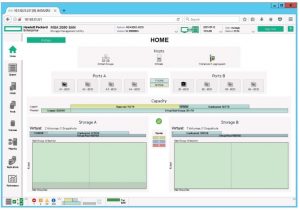

مدیریت استوریج

بعد از نصب، آرایه HPE MSA از طریق یک رابط مرورگر وب به نام Storage Utility Management (SMU)

قابل تنظیم و مدیریت می باشد. SMU به مدیران ذخیره سازی یک راه ساده برای انجام کارهای روزمره نظیر: نظارت بر سلامت اجزای سیستم، ایجاد استخر ذخیره سازی و مدیریت گروه های دیسک و حجم مجازی را می دهد. SMU اجازه ایجاد میزبانانی را می دهد که توانایی ارتباط با آداپتور میزبان WWNs را دارند و می توانند به عنوان بخشی از SAN به صورت IQNs شناخته شوند. سپس این گونه میزبانان می توانند به منظور کنترل دسترسی به ولوم های مجازی نگاشت شوند. علاوه بر SMU ، یک ابزار خط فرمان نیز در دسترس است که توانایی اجرای تمام ویژگی های پیاده سازی شده در GUI سیستم را دارد.

SMU ( ابزار مدیریت استوریج)

مرورگر را باز کنید و IP آدرس پورت شبکه مربوط به ماژول کنترلر را در قسمت نوار آدرس تایپ کنید و کلید ENTER را فشار دهید. کاربر پیش فرض manage و کلمه عبور پیش فرض !manage است. اگر تنظیمات پیش فرض را به دلایل امنیتی تغییر دادید، نام کاربری و کلمه عبور تعیین شده را تایپ کرده و سپس کلید اینتر را فشار دهید.

نکته مهم:

به منظور دریافت اطلاعات بیشتر در مورد نحوه دسترسی و استفاده از SMU، بخش آغازین مربوط به راهنمای HPE MSA 1040/2040 SMU یا HPE MSA 2050 SMU مطالعه کنید. این بخش حاوی دستورات مربوط به ورود به SMU، معرفی مفاهیم کلیدی، نصب آدرس های مرورگر و ارائه نکاتی درباره استفاده از پنجره اصلی و پنجره کمک نرم افزار است.

بخش سوم این مقاله را میتوانید از اینجا مطالعه کنید .

HP G11

HP G11 قیمت سرور HP Gen 10 | مشخصات و خرید سرور اچ پی g10

قیمت سرور HP Gen 10 | مشخصات و خرید سرور اچ پی g10 خرید سرور hp g9 | قیمت سرور اچ پی G9

خرید سرور hp g9 | قیمت سرور اچ پی G9 HP G8

HP G8